728x90

- GPU에 맞는 CUDA 버전을 찾는다.

- GPU의 compute capability를 다음 사이트를 통해 찾는다: https://developer.nvidia.com/cuda-gpus

- 일반적인 그래픽 카드를 사용한다면, CUDA-Enabled GeForce and TITAN Products에서 보면 된다.

- 데스크탑은 왼쪽, 노트북은 오른쪽을 보면 된다.

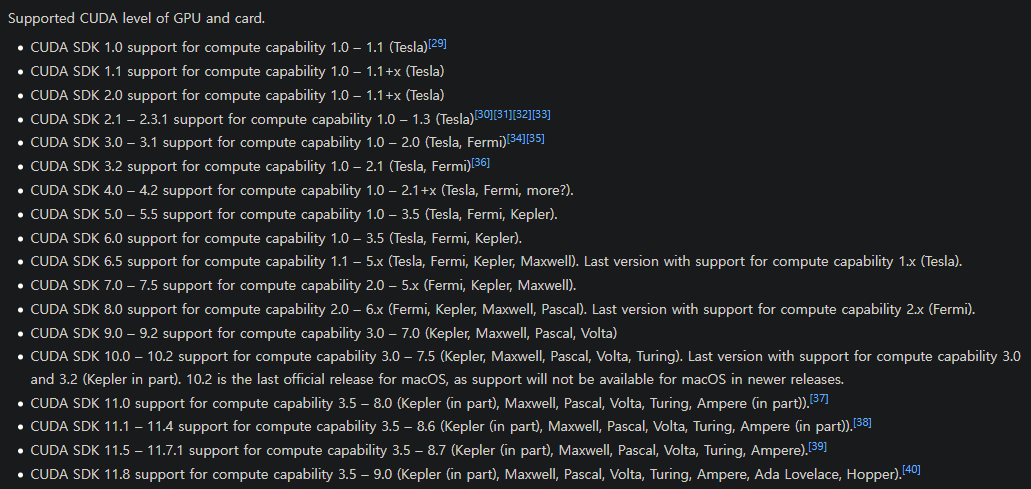

- 다음을 방문하여 본인의 GPU 계산 능력에 호환하는 CUDA 버전을 찾는다: https://en.wikipedia.org/wiki/CUDA

- GPU의 compute capability를 다음 사이트를 통해 찾는다: https://developer.nvidia.com/cuda-gpus

- CUDA+cuDNN 설치

- 본인의 CUDA SDK 버전에 맞춰, 아래 사이트에서 다운로드 하면 된다.

- CUDA의 경우 [사용자 정의 설치 옵션] - [CUDA] - [Runtime/Development] 만 선택하여 설치한다. (Tensorflow기능만 사용할 경우)

- 환경 변수를 확인하여 정상적으로 설치 되었는지 확인한다.

- 환경 변수 - 시스템 변수에서 CUDA_PATH가 있는지 확인한다.

- https://developer.nvidia.com/cuda-toolkit-archive

- cnDNN 설치 (로그인 필요)

- 8.6버전이 최신이므로, 아래의 사이트에서 받고

- https://developer.nvidia.com/rdp/cudnn-download

- 8.6버전 이하는 아래 사이트에서 받으면 된다

- https://developer.nvidia.com/rdp/cudnn-archive

- cuDNN의 경우, bin 폴더 부터 모두 Program Files\NVIDIA ~\CUDA\버전명\ 에 붙어넣기 해준다.

- 본인의 CUDA SDK 버전에 맞춰, 아래 사이트에서 다운로드 하면 된다.

딥러닝 라이브러리 설치 (PyTorch 혹은 Tensorflow)

Pytorch 혹은 Tensorflow 둘 중 하나를 선택하여, 설치해야 한다.

두 개를 동시에 설치할 경우, CUDA 기능을 쓸 수 없게 된다. (CPU 연산 밖엔 안된다.)

- PyTorch 설치

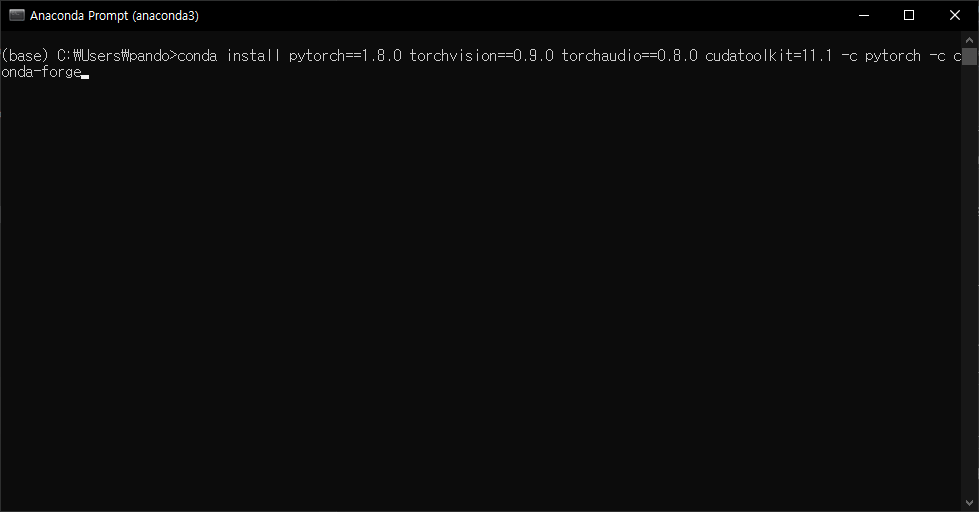

- 아래 주소에서 자신의 CUDA 버전과 환경에 맞춰 명령어를 찾으면 된다.

https://pytorch.org/get-started/previous-versions/ - 명령어를 찾은 경우, pip나 conda의 명령창에 명령어를 입력한다.

- Pytorch가 설치 될 경우 다음 코드를 확인해보면 된다.

import torch torch.cuda.get_device_name() # CUDA를 실행하고 있는 기기 이름을 나타낸다. torch.cuda.is_available() # CUDA의 활성 여부를 나타낸다.

- Tensorflow 설치

- pip freeze | find "tensorflow" 를 통해 Tensorflow와 호환되는 CUDA / cuDNN 프로그램을 찾는다.

- Tensorflow와 호환되는 CUDA / cuDNN은 다음 사이트를 통해 찾을 수 있다: https://www.tensorflow.org/install/source_windows

- 다음 코드를 통해 설치가 되었는지 확인한다.

from tensorflow.python.client import device_lib device_lib.list_local_devices()- 다음과 같은 결과가 나왔다면 설치가 완료 된 것이다.

[name: "/device:CPU:0" device_type: "CPU" memory_limit: 268435456 locality { } incarnation: 7069532473458925051 xla_global_id: -1, name: "/device:GPU:0" device_type: "GPU" memory_limit: 4149673984 locality { bus_id: 1 links { } } incarnation: 2764343345699402071 physical_device_desc: "device: 0, name: GeForce RTX 2060, pci bus id: 0000:01:00.0, compute capability: 7.5" xla_global_id: 416903419] '''- 기타

- 출처 및 참고자료

- 호환되는 버전 찾기: https://coding-groot.tistory.com/87

- Pytorch 설치 확인: https://normal-engineer.tistory.com/234

- Tensorflow GPU 설치 확인 코드: https://bskyvision.com/769

- Tensorflow 2.8.0 설치 참고: https://afsdzvcx123.tistory.com/entry/인공지능-그래픽카드-버전에-맞는-CUDA-버전-성능-확인

- 참고

- Tensorflow와 호환하지 않는 CUDA / cuDNN을 설치할 경우, 일부 모델(필자의 경우 CNN에서만)에서 학습이 진행되지 않을 수 있다.

- Epoch 1/20 와 같이 뜨기만하고, 주피터 노트북 상에서 실행은 되지만, 작업관리자에서 GPU의 작업량은 올라가지 않는 현상이 발생한다.

- 따라서, 본인이 설치한 Tensorflow 버전에 맞춰 CUDA / cuDNN을 설치해야 한다.

(아나콘다를 다시 깔고, 쿠다를 몇번 지웠다 설치하기를 반복하며 얻은 결과이다.)

(두번 다시 이런 삽질을 하지 않기 위해, 블로그에 해결책을 기록해 둔다.) - Tensorflow는 몇달 전에 설치하고, 최근에 Torch를 설치하였다. GPU버전은 Torch가 설치하기 편했다.

- 출처 및 참고자료

728x90

'컴퓨터 관련 > 인공지능' 카테고리의 다른 글

| [Numpy] 슬라이싱한 2차원 이상 배열의 접근, 대입, 계산 (0) | 2021.04.11 |

|---|